看看下面的图片,你认为它是现实生活中拍摄的还是人工智能生成的?

看起来有点可疑,比如有一些车门叠在一起,看起来是拼接在一起的。

下面这两个呢?

如果不仔细查看,你可能不会相信:它们都是“实拍照片”。

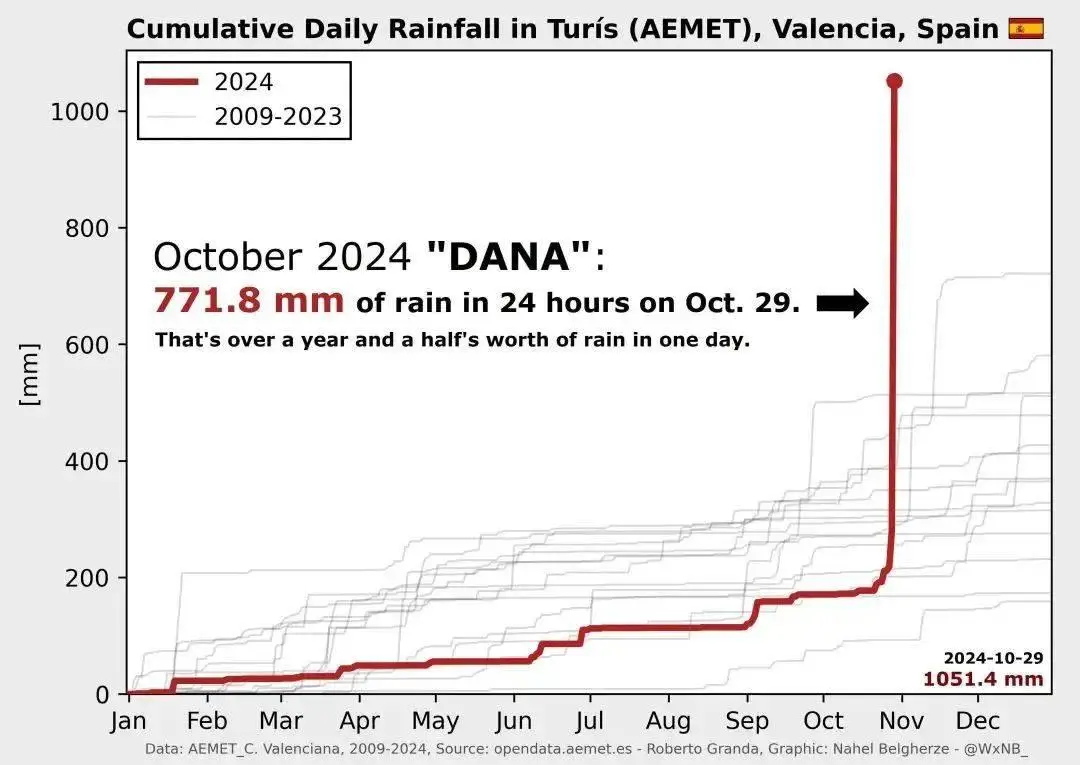

10月底以来,西班牙巴伦西亚地区遭遇强降雨。一天的降雨量相当于一年的降雨量,而且还在持续下雨。

在瓦伦西亚地区,街道坡度很大,这么大的水量可以完全把车漂起来,沿着坡度一路走下去。终于,当洪水退去时,原来照片中的场景出现了。

但面对这些照片,很多人的反应是:AI干的,假新闻。

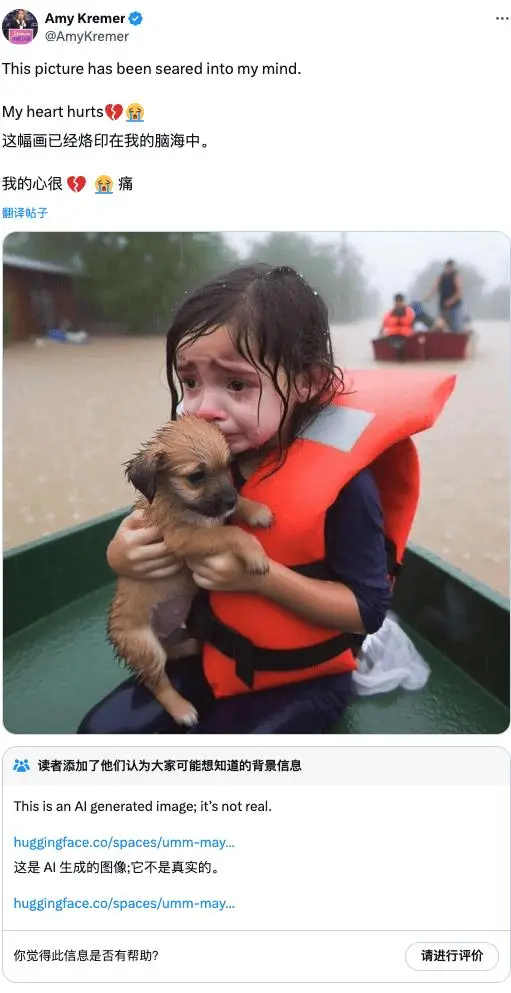

不能说这些人不讲道理,他们确实是被骗了。美国佛罗里达州遭遇飓风袭击时,一名身穿救生衣的小女孩被拍到。他在救生艇上抱着小狗哭泣的照片刷屏了社交网络。

仔细一看,这张图比上面的暴雨图更有“AI味”。从手指的细节到身体的姿势,都有一种难以形容的怪异。

果然,原帖作者并不知道这张图片的出处。他发帖只是为了表达对受灾群众的慰问。

现在,该平台添加了背景信息,以强调这是生成的图像,而不是实际拍摄的“照片”。

在身穿救生衣的女孩的照片中,网友的质疑促使该平台迅速做出回应,并添加了警告。但同样的怀疑在另一场灾难中将不再有效。

毕竟,AI生成的图片确实越来越难辨别真假。而因为一次又一次,总有人利用AI图片来吸引眼球,最终变成了大规模的“狼来了”场景。

越现实,就越危险

在评价AI生成的图像或视频时,是否足够真实一直是最重要的标准之一。

图像是否足够真实、真实,对背后的模型提出了巨大的挑战:它能否掌握自然语言的规则?你了解现实世界的常识和规律吗?你能理解上下文中的信息并呈现出来吗?

这是对模型能力的考验,也是反映各个企业技术能力的有效指标。

一开始,每个人都对人工智能生成极其逼真的图像的能力感到兴奋。但后来越来越多的新闻出现“你先从一张图开始,剩下的都是编出来的”,也越来越难以辨别。

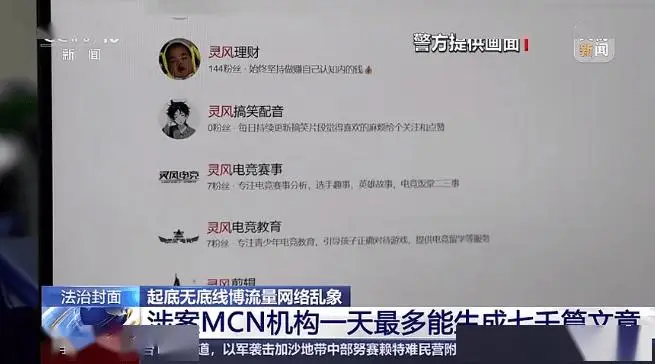

6月,社交媒体上出现了西安发生大爆炸的消息,并明确注明了时间和地点。但西安警方核实后发现,事实并非如此。此消息是使用 MCN 组织持有的帐户发送的。

被警方抓获后,主犯承认自己使用了人工智能工具。根据提示,该工具会自动抓取互联网上的相关文章,然后生成数百至数千字的文本。

高峰时,它每天可以生成4000到7000条信息,整个过程几乎不需要人为参与,而且专门挑选与民生和热点相关的话题和事件——研究表明,负面、负面、负面的信息情感刺激的信息通常更容易捕捉。人类的注意力是由顶叶和额叶的结构决定的。

经过一番操作,骗子仅通过发布虚假新闻、为平台引流,日均收入就高达1万元。阅读、转发、评论此类虚假新闻的用户愤怒在所难免。

假照片以假乱真的,欺骗了大家,引起市场恐慌。去年5月,一张五角大楼爆炸的照片迅速流传。

这张照片在得到专业新闻机构证实之前迅速流传。由于该消息恰巧在当天美国股市开盘时发布,多家投资相关网站和社交媒体账号纷纷转发,导致标普500指数下跌0.3%。黄金和美国国债价格小幅上涨,部分投资者将资金转移至更稳定的产品。

最后,辖区消防部门出面辟谣,平息事态。

过于依赖“眼见为实”不仅会伤害你的感情,还会伤害你的钱包。于是就有了逆向操作:全部贴上AI的标签。

逆向操作,只要你不认识,都是AI图

这样做至少有一个原因:避免平台的推送。

Meta明确表示将高举AI大旗。扎克伯格认为,有必要为人工智能生成或辅助的内容添加专门的版块。他说,“我非常有信心,在未来几年里,这将成为重要的趋势之一和重要的应用之一。”

Meta拥有两个重要的内容平台:Facebook和Instagram。就前者而言,人工智能生成的内容变得越来越普遍,因为它的激励政策非常有吸引力:每条点赞数超过 1000 的帖子,你可以获得最高 10 美元的曝光度。奖。

有一件事要说的是,如果我们能够坚决执行“全部贴上AI标签”的路线,有效打击虚假新闻的传播,并迫使平台停止对这些内容进行引流和补贴,也许这将是一个可行的做法。没有买卖,就没有伤害。

然而,这种真假难辨的情况,可能会导致真正的危害消失在互联网的信息海洋中。

互联网观察基金会报告称,过去六个月人工智能产生的非法内容数量已超过上一年的总量。而且都可以在社交平台、公共图片库等公共平台上找到。

这些非法内容包括人工智能生成的儿童色情图片和视频;包含名人照片的 Deepfake 视频;生成儿童性虐待等裸照。

更严重的问题是人工智能生成的内容已经到了临界点。由于它们过于真实,工作人员无法轻易确定假图片中是否有真人,以及儿童是否真的受到虐待并需要干预。

作为非营利组织,国际货币基金组织等机构只能收集证据并与平台协商要求移除。只有警察和其他执法人员才真正有能力进行进一步调查。

当大量生成的照片需要经过它们处理,而这些照片栩栩如生,无人能分辩时,“全部贴上AI标签”就会导致真实照片混入其中,无法识别,从而错过了真实的照片。干预的机会。

IWF 的分析师表示:“我们处理的几乎所有包含人工智能生成的儿童性虐待材料的报告或链接都可以在明网中找到。像我们或警察这样的组织可能会接触到数百或数千张新照片。这些图像令人难以抗拒,我们并不总是知道是否真的有一个孩子需要帮助”。

同样,随着“狼来了”游戏的不断扩大,真实反映和报道危险情况的新闻被安装为“人工智能来做”,从而错过了最佳救援时间,这也是一个负面后果。

在从“眼见为实”到“眼见为实”的过程中,消失的是上网时的信任。为了自我保护,为了减少谣言的传播,给所有人贴上人工智能的标签确实是一个有效的策略。但一个没有什么值得相信的世界会更好吗?

本文采摘于网络,不代表本站立场,转载联系作者并注明出处:http://www.mjgaz.cn/fenxiang/272757.html