机器之心报道

机器之心编辑部

有人用 LLM 来审查有关 LLM 的论文?

这个星期,每个 AI 研究组都在忐忑地等候着全球顶会 CVPR 2025 放出榜单。

AI 领域的热度逐年提升,今年的审稿工作面临着时间紧迫且任务繁重的情况。直至北京时间周四凌晨,论文接收的结果才开始逐步被上传至 OpenReview 上。大会官方称,预计项目主席将会很快向所有作者发送电子邮件,以介绍更多的详细信息,这些信息中包含着最终评审的分数。

许多研究者也已经在社交网络上分享了论文被接收的喜悦:

深圳大学四年级本科生 Tianxing Chen(陈天行)即将前往香港大学读博,他宣布自己有三篇论文被 CVPR 2025 接收。

接收率为 22.1%。

去年提交了 11532 篇,接收了 2719 篇,接收率为 23.6%。与去年相比,今年大会的录取率创下了历史新低。由此可见,今年的计算机视觉行业更为火热,竞争也更为激烈。

同属 AI 全球顶会的 ICLR 2025 选择了扩大录取范围,其接收率为 32.08%。NeurIPS 2024 也选择了扩大录取范围,接收率是 25.8%。CVPR 的“严格把关”引发了人们的讨论。对此,官方表明大会主办方不会特意去引导论文的录取比例。论文能否被接收,是由 AC(领域主席)对论文做出的原始且独立的决定。

然而事情没有这么简单。

论文接收结果放出的时候,CVPR 对部分审稿人进行了声讨。

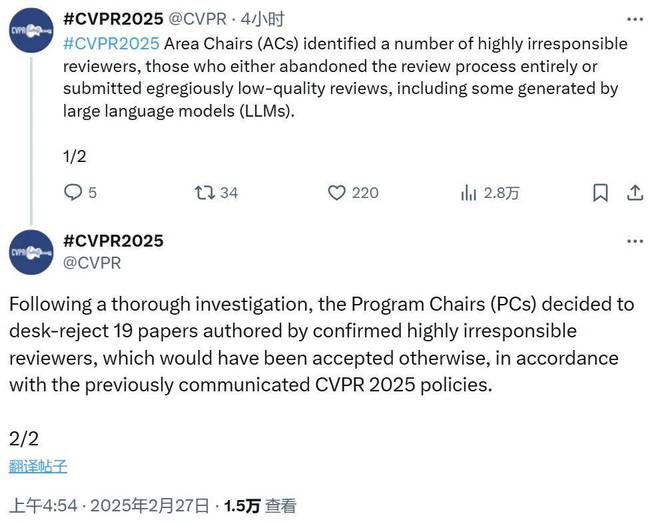

CVPR 2025 的官方推特称,领域主席(Area Chair/AC)察觉到了一些极为不负责任的审稿人。这些审稿人有的完全不再进行审稿流程,有的提交了质量极差的审稿结果,并且其中有一些结果是由大型语言模型(LLM)生成的。

CVPR 官方公布了事件处理结果。经过彻底调查后,项目主席(PC)决定拒收 19 篇论文。按照之前传达的 CVPR 2025 政策,这些论文原本可被接收,然而它们的作者都已被认定为极不负责任的审稿人。

CVPR 官方未公布这些“不负责任的审稿人”的名单。有人觉得若公布人名,此举将具有更大的威慑力。

有人补充道,不负责任的审稿人包含两类。一类是那些利用大语言模型来撰写评审的人;另一类是那些在审稿过程中敷衍对待,并且没有给出明确理由就拒绝竞争者论文的人。

Meta 研究科学家 Felix Juefei Xu 把自己对这件事的想法整理成了一条长推文。他关注被惩罚的审稿人的合作者,这些合作者原本没有过错,却因审稿人的失职而一同受到拒收惩罚。他觉得这是一种大锤猛砸的方法,而手术刀式的处理或许会更仁慈。

我们的读者朋友对此有何看法呢?是否认为这种惩罚对其他合作者而言并不公平呢?

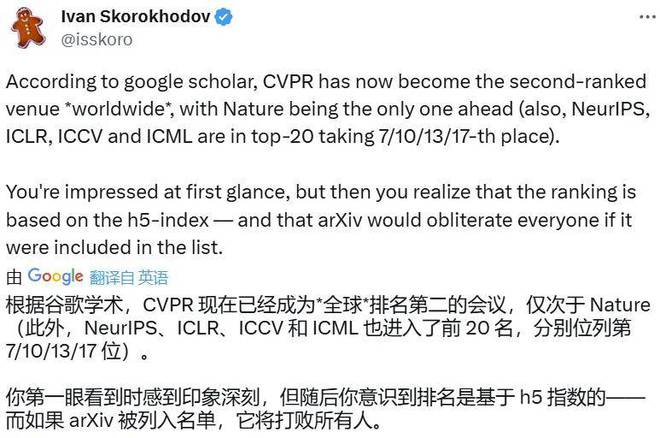

此外,AI 学术界在热议 CVPR 2025 论文的接收情况。Snap 研究科学家 Ivan Skorokhodov 发现,CVPR 会议的谷歌学术排名(h5 指数)上升到了第二名。它仅次于《Nature》,并且超过了《新英格兰医学杂志》和《Science》。这两份杂志都享誉已久。

把所有学科都算上,全球第二。

CVPR 进入了前 20 名,位列第 4 位。NeurIPS 进入了前 20 名,位列第 7 位。ICLR 进入了前 20 名,位列第 10 位。ICCV 进入了前 20 名,位列第 13 位。ICML 进入了前 20 名,位列第 17 位。

这个排名是基于 h5 指数的,h5 指数指的是过去 5 年内发表的文章的 h 指数。也就是说,它并没有计算发布在 arXiv 上的论文的引用情况。因此,如果把这些引用加进来,Nature 很可能就会失去谷歌学术排名第一的宝座。

AI 研究真算得上是热潮汹涌!

你是否投稿了 CVPR 2025 会议,接收情况如何呢?

本文采摘于网络,不代表本站立场,转载联系作者并注明出处:http://www.mjgaz.cn/fenxiang/274586.html